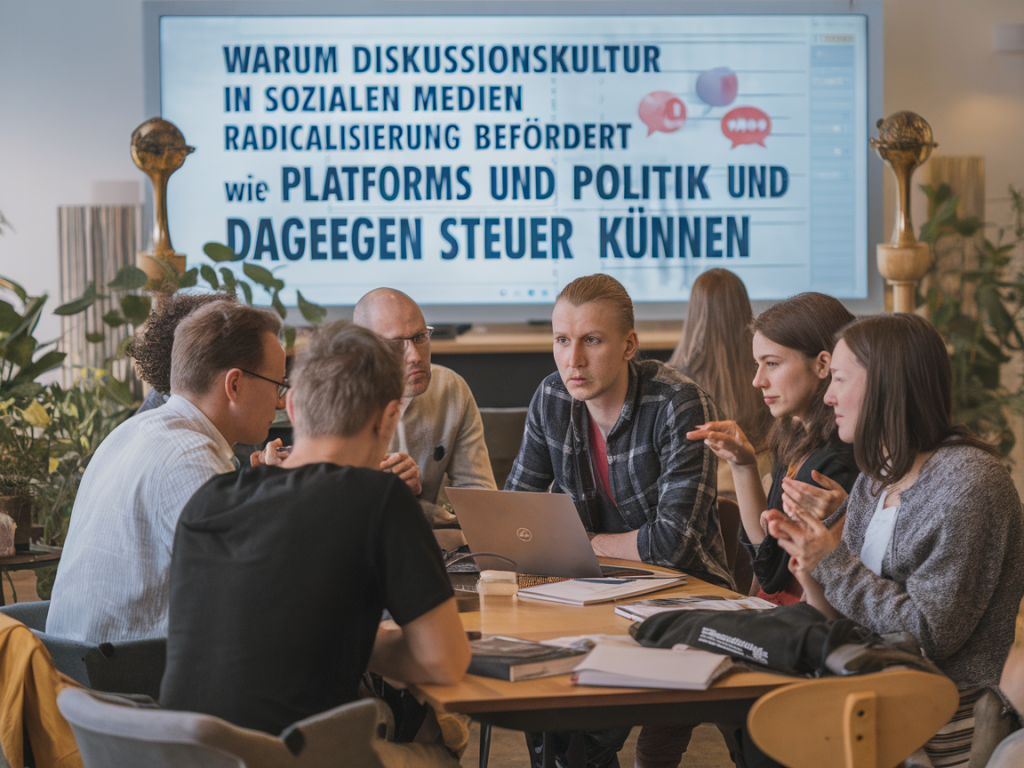

Immer wieder erlebe ich in meiner Arbeit, wie hitzige Debatten im Netz nicht selten in verhärteten Fronten oder gar in radikalen Positionen münden. Als Journalistinnen und Journalisten, aber auch als Nutzerinnen und Nutzer tragen wir gemeinsam Verantwortung dafür, wie öffentliche Kommunikation im digitalen Raum verläuft. In diesem Beitrag möchte ich aus meiner Perspektive erklären, warum die Diskussionskultur in sozialen Medien Radikalisierung fördert und welche Hebel Plattformen und Politik ansetzen könnten — und müssen —, um dagegenzusteuern.

Warum soziale Medien Radikalisierung befördern

Soziale Netzwerke sind keine neutralen öffentlichen Plätze. Ihre technische Architektur, Geschäftsmodelle und Nutzermechaniken formen Kommunikation aktiv mit. Drei Mechanismen halte ich dabei für besonders zentral:

Engagement-getriebene Algorithmen: Plattformen wie Facebook, X (ehemals Twitter), YouTube oder TikTok belohnen Inhalte, die Reaktionen auslösen — Empörung, Empathie, Schock. Solche Inhalte werden oft polarisiert oder vereinfachend produziert, weil sie Klicks, Shares und damit Umsatz generieren.Echokammern und Filterblasen: Nutzer*innen sehen häufiger Inhalte, die ihrem Weltbild entsprechen. Algorithmen verstärken das, weil sie vorherige Interaktionen als Signal für Präferenzen werten. Wer einmal in eine radikale Community abrutscht, trifft dort zunehmend auf Bestätigung statt auf Widerspruch.Anreize für Vereinfachung und Personalisierung: Komplexe politische Zusammenhänge lassen sich schlecht in 280 Zeichen erklären. Populäre Narrative, Verschwörungserzählungen oder vereinfachte Schuldzuweisungen bieten Abkürzungen, die leicht zu teilen sind und starke emotionale Bindungen schaffen.Diese technischen und ökonomischen Faktoren treffen auf menschliche Psychologie: Bestätigungsfehler, soziale Identität und das Bedürfnis nach Zugehörigkeit verstärken radikale Dynamiken. Hinzu kommt das Verhalten extremistischer Akteur*innen, die Plattformen gezielt als Rekrutierungs-, Vernetzungs- und Propagandainstrument nutzen.

Wie Radikalisierung konkret entsteht — ein typischer Pfad

In Recherchen und Gesprächen habe ich wiederholt ähnliche Muster beobachtet:

Ein*e Nutzer*in folgt aus Interesse bestimmten politischen Seiten oder Hashtags.Die Plattform empfiehlt ähnliche, aber zunehmend radikalere Inhalte.Interaktionen (Likes, Kommentare) führen zu engeren Verflechtungen mit radikalen Communities.Durch Gruppenzwang und Identity-Building entstehen neue altogehört-Gefühle; extremes Denken wird normalisiert.Dieser Prozess ist graduell — nicht jede neue Meinung ist schon Radikalität. Aber die Beschleunigung und Verstärkung durch Technologie erhöht die Wahrscheinlichkeit des Überschlags.

Welche Maßnahmen Plattformen ergreifen können

Plattformen haben technische und personelle Hebel. Einige davon werden bereits diskutiert oder teilweise umgesetzt; andere sollten mutiger ausprobiert werden.

Algorithmische Dämpfung von Polarisierung: Recommendation-Systeme sollten nicht nur Engagement, sondern auch Qualitäts- und Vertrauenssignale berücksichtigen. Das heißt: Quellenstärke, Vielfalt der Perspektiven und Kontextualisierung können höher gewichtet werden.Transparenz und Kontrollrechte für Nutzer*innen: Nutzer*innen müssen nachvollziehen können, warum ihnen etwas angezeigt wird. Einstellbare Algorithmen (z. B. "neutraler Modus", "chronologische Ansicht") und klare Erklärungen sind wichtig.Fakt-Checking und Kontextualisierung: Plattformen sollten Faktenchecks leichter sichtbar machen und Desinformation nicht einfach durch Downranking bestrafen, sondern erklären, warum Inhalte problematisch sind.Design, das Reibung einführt: Kleine Hürden (Warnhinweise, Bedenkseiten vor dem Teilen) können impulsives Verhalten reduzieren — ohne die Meinungsfreiheit unverhältnismäßig zu beschneiden.Stärkere Moderation und Community-Standards: Das erfordert sowohl automatisierte Tools als auch gut geschulte menschliche Moderator*innen, die kulturelle Nuancen verstehen.Unterstützung von Gegenöffentlichkeiten: Förderung vertrauenswürdiger Quellen, lokaler Medien und zivilgesellschaftlicher Initiativen, die Debatten versachlichen.Was Politik tun kann — rechtlich, finanziell, institutionell

Politik darf sich nicht allein auf Selbstverpflichtungen der Plattformen verlassen. Regulierungsdruck ist nötig, aber mit Bedacht:

Klare Regeln für Transparenzpflichten: Plattformen sollten Berichtspflichten haben: Wie funktionieren ihre Empfehlungsalgorithmen? Welche Inhalte werden wie monetarisiert? Wer betreibt politische Werbung?Datentransparenz für Forschung: Unabhängige Forscher*innen benötigen Zugang zu aggregierten, anonymisierten Daten, um Wirkmechanismen zu untersuchen und Maßnahmen zu evaluieren.Haftungs- und Sorgfaltspflichten: Im Sinne eines digitalen Gesundheitsschutzes könnten Betreiber verpflichtet werden, Risiken (z. B. Radikalisierungspotenziale) zu minimieren — vergleichbar mit Produktsicherheitsstandards.Förderung zivilgesellschaftlicher Bildung: Medienkompetenz gehört in Schulen, aber auch in Weiterbildung für Erwachsene. Politische Bildung muss digitale Öffentlichkeit mitdenken.Finanzielle Förderung für Qualitätsjournalismus: Lokaljournalismus und investigative Recherche sind Gegengewichte zu viralem, oft unreflektiertem Content.Internationale Kooperationen: Digitale Kommunikation kennt keine nationale Grenze. Europäische und internationale Standards sind nötig, um Schlupflöcher zu schließen.Maßnahmen im Vergleich

| Maßnahme | Vorteile | Risiken / Herausforderungen |

| Algorithmische Diversifizierung | Mehr Perspektiven, weniger Echokammern | Komplexe Implementierung; mögliche Nutzerunzufriedenheit |

| Warnhinweise / Friktionen | Reduziert impulsives Teilen | Weniger effektiv bei zielgerichteter Desinformation |

| Transparenzpflichten | Erhöht Rechenschaft, ermöglicht Forschung | Wettbewerbs- und Datenschutzfragen |

| Förderung von Medienkompetenz | Längerfristig stärkere Resilienz der Bevölkerung | Langfristiger Effekt; politische und finanzielle Priorität erforderlich |

Warum Verbote allein nicht genügen

Ein reflexhaftes Verbot bestimmter Inhalte klingt attraktiv, greift aber oft zu kurz. Repressive Maßnahmen können in den Untergrund treiben, wo Radikale ungestört agieren. Sinnvoller ist ein Mix aus Prävention, Transparenz und klarer Moderation. Außerdem müssen Grundrechte wie Meinungsfreiheit und Pluralität gewahrt bleiben — das ist kein Randargument, sondern zentral, um demokratische Gegenöffentlichkeiten zu schützen.

Praktische Vorschläge für die nächsten Schritte

Plattformen sollten Testfelder für algorithmische Anpassungen öffnen und Ergebnisse öffentlich evaluieren.Politik und Zivilgesellschaft sollten ein European Digital Civic Resilience Fund einrichten, der Projekte zur Demokratieförderung und Medienbildung unterstützt.Firmen wie Meta, X, ByteDance (TikTok) und Google/YouTube sollten verpflichtende Audits ihrer Empfehlungsalgorithmen durch unabhängige Dritte akzeptieren.Schulen brauchen Curricula, die digitale Debattenkompetenz, Erkennen von Manipulation und konstruktive Streitkultur verbinden.Ich glaube, es ist möglich, digitale Diskussionsräume so zu gestalten, dass sie demokratische Debatten stärken, statt sie zu schwächen. Das erfordert technische Innovationen, gesetzliche Rahmenbedingungen und eine kulturelle Rückbesinnung auf argumentativen Austausch. Plattformen, Politik und Zivilgesellschaft müssen vernetzt handeln — sonst riskieren wir, dass öffentliche Kommunikation weiterhin zu einem Nährboden für Polarisierung und Radikalisierung wird.